En la era digital, los datos se han convertido en uno de los activos más valiosos para las empresas. Ya sea para entender a los clientes, vigilar a la competencia o automatizar procesos internos, acceder a la información adecuada marca la diferencia. En este contexto, la técnica de scraping web ha ganado protagonismo como una de las herramientas más eficaces para recolectar datos estructurados desde cualquier página web pública.

En MITSoftware, como expertos en soluciones digitales personalizadas, apostamos por el scraping como una vía inteligente para que nuestros clientes tomen decisiones basadas en información real y actualizada.

¿Qué es la técnica de scraping web?

El web scraping o scraping web es una técnica automatizada que permite extraer grandes volúmenes de datos de sitios web. Esta técnica simula el comportamiento de un usuario al navegar por una página, pero de forma automatizada, rápida y masiva. Gracias a la técnica de scraping web, es posible obtener desde listas de productos y precios, hasta noticias, publicaciones, imágenes, metadatos y más.

A diferencia de otras metodologías como el uso de APIs, el scraping ofrece mayor flexibilidad y se puede aplicar incluso cuando una plataforma no expone sus datos de manera directa o abierta.

¿Cómo funciona el scraping?

La base de cualquier técnica de scraping web es el análisis del código HTML de la página objetivo. Mediante herramientas como Python y bibliotecas como BeautifulSoup, Scrapy o Selenium, se automatiza el proceso de:

- Realizar una solicitud a la página web.

- Analizar el DOM (modelo de objetos del documento).

- Extraer los elementos deseados.

- Almacenar la información en un formato útil (CSV, Excel, JSON, base de datos, etc.).

- Automatizar la ejecución del script para una recolección continua.

Para aprender más sobre los conceptos técnicos detrás de este proceso, puedes explorar la documentación oficial de Scrapy y también este recurso en MDN Web Docs que explica cómo se estructura el HTML.

Aplicaciones de la técnica de scraping web

En MITSoftware hemos implementado soluciones de scraping en múltiples sectores, demostrando que esta técnica puede adaptarse prácticamente a cualquier necesidad empresarial. Estos son algunos de los usos más destacados:

1. Comercio electrónico

El scraping en e-commerce permite monitorear precios de la competencia, detectar cambios en productos y analizar tendencias del mercado en tiempo real. Esto proporciona una ventaja competitiva directa, especialmente para negocios que operan en marketplaces como Amazon o eBay. Un artículo de ParseHub detalla cómo este tipo de prácticas ya están siendo utilizadas por miles de tiendas en línea.

2. Sector inmobiliario

Muchas agencias utilizan scraping para extraer datos de portales inmobiliarios como Idealista, Habitaclia o Fotocasa. Esto les permite realizar análisis de precios por zonas, detectar nuevas oportunidades de inversión o evaluar la evolución del mercado.

3. Finanzas y criptomonedas

Mediante la técnica de scraping web, es posible recolectar información financiera en tiempo real: cotizaciones bursátiles, cambios en el tipo de cambio, precios de criptomonedas, etc. Sitios como World Bank Data también permiten enriquecer los resultados con estadísticas macroeconómicas confiables.

4. Análisis de contenido y reputación online

Los especialistas en marketing digital aplican scraping para monitorear menciones de marca, analizar reseñas de usuarios, estudiar contenidos de la competencia y generar dashboards de reputación. Este enfoque se utiliza ampliamente en estrategias de social listening y benchmarking.

5. Investigación académica y periodismo de datos

Los investigadores y periodistas pueden automatizar la recolección de información desde múltiples fuentes, facilitando el análisis de fenómenos sociales, económicos o políticos. Harvard JOLT incluso ha explorado los aspectos legales del scraping en el ámbito académico.

Beneficios clave del scraping para las empresas

La adopción de la técnica de scraping web no solo se trata de automatizar tareas: se trata de convertir datos dispersos en decisiones informadas. Entre sus principales ventajas encontramos:

- Recopilación de datos masivos en poco tiempo.

- Automatización de procesos que antes requerían intervención humana.

- Mejora en la toma de decisiones gracias a datos actuales y personalizados.

- Detección temprana de oportunidades y riesgos del mercado. -Integración con inteligencia artificial para análisis predictivo o categorización automática.

En McKinsey & Company destacan cómo las organizaciones orientadas a datos superan a su competencia en eficiencia y capacidad de reacción.

¿Es legal la técnica de scraping web?

Esta es una de las preguntas más comunes. Y la respuesta es: sí, con condiciones. La legalidad del scraping depende de:

- El respeto a los términos de uso del sitio web.

- No acceder a contenido privado o protegido por credenciales.

- No almacenar ni tratar datos personales sin consentimiento (importante en Europa bajo el RGPD).

- No generar un uso excesivo de recursos del servidor, lo cual podría considerarse un ataque.

En MITSoftware diseñamos proyectos de scraping totalmente legales y éticos. Siempre consultamos el archivo robots.txt del sitio web objetivo y ofrecemos asesoramiento legal especializado cuando es necesario. Puedes consultar esta guía legal sobre scraping para profundizar en el tema.

Herramientas más usadas para scraping

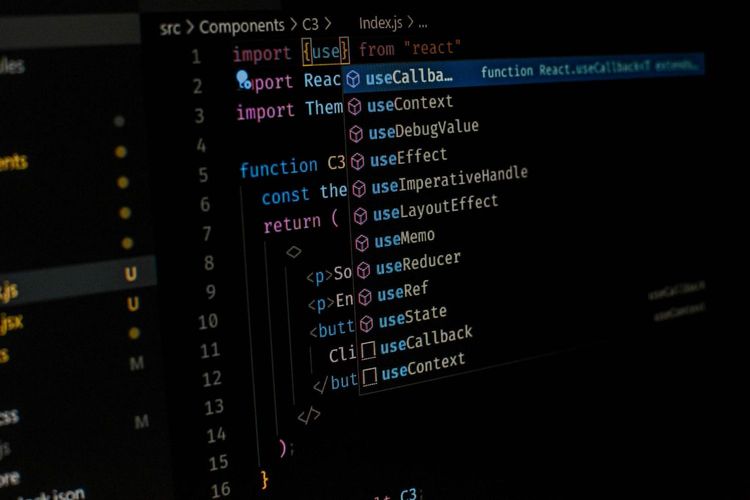

La elección de herramientas dependerá de la complejidad del sitio, el tipo de datos que se necesiten y el volumen esperado. Algunas opciones populares incluyen:

- Python + BeautifulSoup: Ideal para scraping sencillo en sitios estáticos.

- Scrapy: Potente framework para proyectos de gran escala.

- Selenium: Recomendado cuando el sitio genera contenido dinámicamente con JavaScript.

- Puppeteer: Orientado a desarrolladores que prefieren trabajar con Node.js.

También existen herramientas visuales sin código como Octoparse o ParseHub, que permiten a usuarios no técnicos realizar scraping con interfaces amigables.

Una excelente comparativa de herramientas se encuentra en esta publicación de Towards Data Science.

¿Cuándo conviene usar una API en lugar de scraping?

Aunque la técnica de scraping web es poderosa, si un sitio ofrece una API pública bien documentada, lo ideal es utilizarla. Las APIs suelen ser más estables, rápidas y seguras. Sin embargo, muchas veces no proporcionan todos los datos deseados, o tienen límites de uso demasiado restrictivos. Ahí es donde el scraping se vuelve una alternativa viable y eficaz.

¿Por qué MITSoftware es tu mejor aliado en scraping?

En MITSoftware no solo desarrollamos scrapers. Creamos sistemas completos de extracción, procesamiento y visualización de datos. Nuestra experiencia abarca sectores como retail, banca, real estate, travel y tecnología. Lo que nos distingue:

-Soluciones personalizadas y escalables. -Procesos 100% seguros y cumpliendo normativa. -Dashboards integrados con BI y CRM. -Enriquecimiento de datos mediante machine learning. -Capacidad de scraping internacional (idiomas, monedas, zonas horarias)..

La técnica de scraping web es mucho más que un método técnico: es una ventaja estratégica. Al permitir que tu empresa acceda a información en tiempo real desde cualquier fuente digital, estarás mejor preparado para anticiparte al mercado, optimizar procesos y competir con inteligencia.

En MITSoftware estamos listos para ayudarte a transformar el desorden de datos en conocimiento útil. Diseñamos scrapers a medida que se adaptan a tus necesidades reales, sin importar la industria o el tamaño de tu empresa.